温馨提示:这篇文章已超过368天没有更新,请注意相关的内容是否还可用!

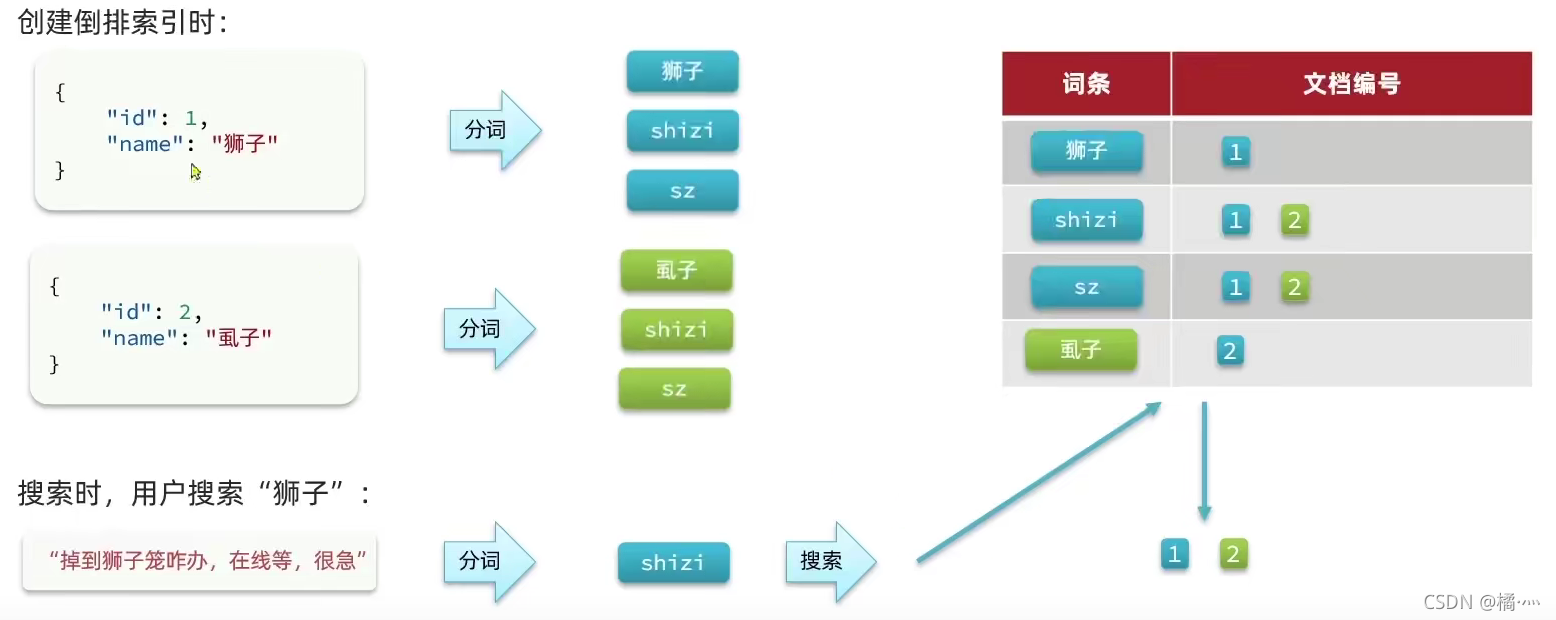

1、这些算法称为 Tokenizer分词器 , 这些Token会被进一步处理, 比如转成小写等, 这些处理算法被称为 Token Filter词元处理器 ,被处理后的结果被称为 Term词 , 文档中包含了几个这样的Term被称为 Frequency词频。

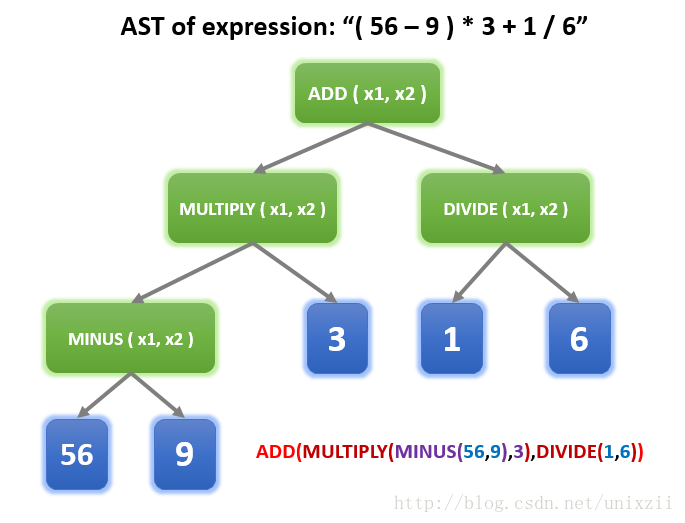

2、Tokenize,即将文本转化为Token序列的过程,是自然语言处理中的关键步骤这个过程通常包括分词将文本划分为单词或词组和可能的词性标注为每个单词或词组标注其词性例如,对于句子quotI like applesquot,Tokenize后的结果可能是quotIquot, quotlikequot, quotapplesquot, quotquot,每个元素都是一个TokenTokenizer是。

3、其中 token 为分词结果 start_offset 为起始偏移 end_offset 为结束偏移 position 为分词位置下面来看下 Simple Analyzer 分词器它只包括了 Lower Case 的 Tokenizer ,它会按照 非字母切分 , 非字母的会被去除 ,最后对切分好的做 转小写 处理,然后接着用刚才的输入文本。

4、solrStandardTokenizerFactoryquotltanalyzerltfieldType元素的类名称不是一个真实的分词器,但是它指向一个实现了接口的类这个工厂在需要的时候会创建一个分词器的实例工厂创建出来的对象必须继承。

5、预训之旅 在3TB的丰富数据海洋中,Qwen主要汲取网络文档百科书籍和代码的知识,覆盖多语言,尤其注重中文和英文,且配备了高效的预处理工具 Tokenizer的匠心独运 Qwen采用开源的BPE分词器,拥有152K词表,表现出超越同行的分词精度,尤其在跨语言处理中表现出色 技术突破与优化 Qwen在Transfor。

6、本项目直接加载降级处理后的mT5模型hugging Face库中对应的版本为csebuetnlpmT5_multilingual_XLSum, 输入文本通过tokenizer进行分词得到对应的token id 支持最大长度为512,然后调用generate函数,将编码的输入文本进行解码,目前项目在解码过程中的超参数设置如下支持最大长度max_length=70。

7、生成器, 可以使用for循环来获取分词后得到的每一个词语或者使用 5 jieblcut 以及 jiebalcut_for_search 直接返回list 6 jiebaTokenizerdictionary=DEFUALT_DICT 新建自定义分词器,可用于同时使用不同字典,jiebadt为默认分词器,所有全局分词相关函数都是该分词器的映射。

8、Elasticsearch全文检索默认分词器为standard analyzerstandard analyzer中,character Filter什么也没有做,Token Filters只是把英文大写转化为小写,因此Elasticsearch默认对大小写不敏感,下面主要介绍Tokenizer token分隔符把text分隔为tokenterm数据写入的时候会使用standard analyzer处理,text会被处理为。

9、1ngram分词器Elasticsearch实现模糊搜索 2keyword忽略大小写 Controller Service 大小写兼容搜索,即字段内容为 alan ,搜索 alan ALAN Alan 都可以搜索出来根据 min_gram 以及 max_gram 指定切分时最小几个字符最大几个字符长度越短,切分出来越少,更多的被匹配到质量也越差长度越。

10、对于自然语言处理任务,分词和编码也是必要的步骤使用分词器将文本分割成单词或子词,然后将这些词映射到整数编码,以便模型可以处理你可以使用现有的分词器,如Hugging Face的Tokenizer,或者创建自己的分词器最后,将预处理后的数据分为训练集和验证集大型语言模型在许多自然语言处理任务上取得了显著。

11、至此,一个带中文分词的elasticsearch就算搭建完成 想偷懒的可以下载medcl的elasticsearchRTF直接使用,里面需要的插件和配置基本都已经设置好标准分词standard配置如下curl XPUT localhost9200local d #39 quotsettingsquot quotanalysisquot quotanalyzerquot quotstemquot quottokenizerquot quotstandardquot。

12、quotItalyquot, 紧接着再输入quot,Itquot, 此时字符串为在textview中位 “Italy,It”,那么此时MultiAutoCompleteTextView根据你设置的分词方式CommaTokenizer,分解出 quotItquot,然后再匹配一次, 又会提示Italy这就是Multi的由来支持多个单词的提示,当然必须设置正确的分词方式Tokenizer。

13、letterquot, quotdigitquot, quotpunctuationquot 以上语句中,构建了一个名为“charSplit”的分析器它使用一个名为“ngram_tokenizer”的Ngram分词器可以用如下语句测试charSplit分析器,可以看到一字一词的效果curl POST。

14、分词所得存放于其他数据类型可以下一步处理如果用数组,需要先确定数组长度定义一个足够大的数组是不严谨的java编程风格,所以只能在最后面进行转换List不定长,可以暂时用来保存数据全部词元处理完之后可以进行转化List和数组可以很方便的相互转化public class TokenizerApp public static。

15、自定义词表的构建需要谨慎,需将词表文件放置在tokenizer目录下,并在加载模型时指定务必确保词表内容经过精心筛选和测试,以避免对模型性能产生不利影响Hugging Face的文档和示例代码提供了详细的指导总的来说,RoBERTa CM6的情感分析能力强大,但在实际应用中,需结合具体需求进行调整和优化,以达到。

16、1 收集大量的垃圾邮件和非垃圾邮件,建立垃圾邮件集和非垃圾邮件集 2 提取邮件主题和邮件体中的独立字符串,例如 ABC32,¥234等作为TOKEN串并统计提取出的TOKEN串出现的次数即字频按照上述的方法分别处理垃圾邮件集和非垃圾邮件集中的所有邮件 3 每一个邮件集对应一个哈希表,hash。

还没有评论,来说两句吧...